Scraping

Qu'est-ce que c'est?

Le web scraping permet d'extraire des données du web, de manière plus ou moins automatisées. Concrètement cela permet de récupérer en temps réel des flux d'information, de télécharger automatiquement de grandes quantités de données (à partir de bibliothèques en ligne par exemple), de créer des robots qui "naviguent" sur le web à la recherche d'informations. Les techniques sont multiples et peuvent passer par des API, par des navigateurs automatisés ou, plus simplement par des requêtes http et des techniques d'analyse des pages html reccueillies (le "parsing").

Références

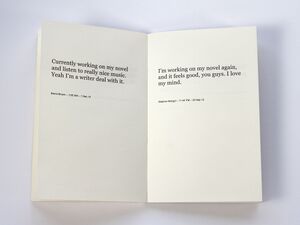

Cory Arcangel, "Working on my novel"

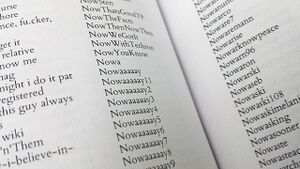

Michael Mandiberg, "Print Wikipedia"

https://en.wikipedia.org/wiki/Print_Wikipedia

Nicolas Maigret, "The Pirate Cinema"

https://disnovation.org/thepiratecinema/installation/

Jonathan Puckey, "Skycatcher Wallpaper" & "Zeitgeist"

https://jonathanpuckey.com/projects/skycatcher-wallpaper/ https://jonathanpuckey.com/projects/zeitgeist/

Michael Bielicky, Kamila B. Richter, Dirk Reinbold, "The Falling Time"

Julius Popp, Bit.Fall

Un scraping "low tech"

Deux exemples sont disponibles sur le gitlab du cours. Le premier scanne une page web à la recherche d'une suite de mot pour en générer des affiches, le deuxième récupère toutes les images d'une recherche donnée. Ils utilisent tous deux les mêmes librairies Python: beautifulsoup et requests.

Voir ici: https://gitlab.com/erg-design-numerique/demos/scraping